I primi studi sull’atomo

Quante persone osservando i piccolissimi granelli di una manciata di sabbia possono aver pensato ai più piccoli e rigidi granelli che costituiscono tutte le forme di materia? L’affermazione esplicita che la materia sia composta da particelle indivisibili chiamata atomi la rintracciamo nell’antica città d’Abdera, sulle coste della Tracia. Là, verso la fine del V secolo a.C., i filosofi greci Leucippo e Democrito insegnavano che tutta la materia è fatta di atomi e di spazio vuoto.

La loro idea degli atomi è sopravvissuta ed è stata ininterrottamente accettata nei millenni successivi. Tale idea consente di spiegare moltissime osservazioni comuni che sarebbero completamente misteriose se si pensasse alla materia come a un continuo che riempie interamente lo spazio. Come possiamo altrimenti comprendere lo sciogliersi di un blocco di sale in una tazza d’acqua se non supponiamo che gli atomi dai quali è composto si diffondano negli spazi vuoti tra atomi d’acqua?

Dopo la nascita della scienza moderna, l’idea degli atomi finì con l’essere utilizzata come base di teorie quantitative della materia. Nel XVII secolo Isaac Newton (1642-1727) tentò di spiegare l’espansione dei gas come il riversarsi improvviso e violento dei loro atomi nello spazio vuoto. Più autorevolmente, all’inizio del XVIII secolo, John Dalton (1766-1844) spiegò i rapporti costanti in termini di peso relativo degli atomi di quegli elementi. Verso la fine del XIX secolo l’idea dell’atomo era diventata familiare alla maggior parte degli scienziati, anche se non tutti l’avevano accettata. Da una parte, a causa dell’eredità lasciata da Newton e da Dalton, vi era in Inghilterra una certa tendenza a ricorrere a teorie atomiche. Dall’altra, in Germania perdurava la resistenza all’atomismo. Non deve sorprendere il fatto che i fisici e i chimici tedeschi fossero chiaramente scettici sugli atomi: sotto l’influenza di una scuola filosofica empiristica che faceva capo a Ernst Mach (1836-1916) di Vienna, molti di essi, infatti, rifiutavano di incorporare nella loro teorie qualsiasi cosa che – come gli atomi – non fosse direttamente osservabile. Altri, come il grande teorico austriaco Ludwig Boltzmann (1844-1906), ricorrevano in realtà a ipotesi atomistiche per spiegare teoricamente fenomeni quale il calore, ma a prezzo del dissenso dei colleghi; si dice che l’opposizione e le critiche da parte dei seguaci di Match contribuirono al suicidio di Boltzmann.

Tutto ciò cambiò nei primi decenni del XX secolo. Stranamente, la generale accettazione della natura atomica della materia si ottenne attraverso le scoperte dei costituenti dell’atomo, l’elettrone e il nucleo atomico, che demolivano la vecchia idea d’indivisibilità degli atomi di Democrito e Leucippo.

La scoperta di queste parti atomiche è da attribuire allo straordinario sviluppo dello studio dei fenomeni elettrici. Il primo passo s’ottenne con lo studio dei gas attraversati da corrente elettrica (nei quali si notò per la prima volta l’esistenza di alcuni raggi chiamati catodici, perché provenivano dal catodo e che si dirigevano verso l’anodo) condotto separatamente dal fisico G. J Stoney (1826- 1911) (il quale propose il nome di elettrone per le particelle cariche negativamente che costituivano i raggi catodici) e dal fisico inglese J. J. Thomson (1856- 1940) ( che trovò nel 1895 il rapporto e/m = 1,76 * 108 C/g).

Nel 1909, in concorrenza con Thomson, il fisico statunitense R.A. Millikan (1868- 1953), ideando un ingegnoso dispositivo sperimentale, riuscì a determinare con soddisfacente precisione il valore della carica dell’elettrone, che, sostituito nel rapporto visto in precedenza, permise di calcolare il valore della massa di queste piccolissime particelle (m= 9,11 * 10-28 g).

Nel 1886 il fisco tedesco E. Goldstein (1850- 1930) aveva scoperto i raggi canale che sono costituiti da particelle cariche positivamente: sono ioni positivi prodotti a seguito dell’impatto dei raggi catodici sugli atomi che formano il gas contenuto nel tubo. Lo ione idrogeno, che si produce quando il gas è contenuto è idrogeno, risulta essere la particella più piccola carica positivamente: chiamato protone dal fisico neozelandese E. Rutherford (1871- 1937), risulterà avere una massa 1836 volte maggiore di quella dell’elettrone, quasi uguale a quella dell’atomo di idrogeno, e una carica uguale, in valore assoluto, a quella dell’elettrone.

La

scoperta di queste particelle conferma, da una parte, la natura corpuscolare

della materia, ma, dall’altra, mette in crisi la supposta indivisibilità

dell’atomo.

Un’altra serie di osservazioni spingerà ulteriormente a collegare la struttura dell’atomo con l’esistenza in esso di varie particelle cariche elettricamente. Nel 1896 il fisico francese A. H. Becquerel (1852- 1908) scopre che un composto di uranio emette spontaneamente radiazioni indivisibili capaci di attraversare un foglio di alluminio posto sopra una scatola contenente lastre fotografiche, le quali restano così impressionate. Da queste osservazioni del tutto casuale prende avvio lo studio accurato dei fenomeni di radioattività, al quale si dedicheranno in modo particolare i coniugi Curie (Maria Sklodowska, 1867- 1934, polacca; Pierre Curie, 1859- 1906, francese).

Rutherford classifica le radiazioni evidenziate nei suddetti fenomeni in tre categorie:

raggi α: sono costituiti da particelle aventi una massa quasi uguale a quella degli atomi di elio, ma con carica elettrica positiva (oggi noi possiamo dire che sono particelle esattamente uguali ai nuclei atomici di elio);

raggi β: sono costituiti da particelle con massa e con carica elettrica uguali a quelle degli elettroni;

raggi γ: non dimostrano natura corpuscolare e non hanno carica elettrica.

I raggi γ, che dimostrarono avere solo natura ondulatoria (cioè si comportano solo da radiazioni e non da corpuscoli). Risultano simili ai raggi X, scoperti dal fisico tedesco W. K. Rontgen (1845- 1923), poco tempo prima dell’osservazione casuale di Becquerel, studiando il comportamento dei raggi catodici.

Le particelle α, poiché hanno una massa relativamente grande non sono molto penetranti e possono essere fermate anche da un foglio di carta. Le particelle β, dotate di massa minore, sono più penetranti, ma possono essere fermate da un foglio di alluminio. I raggi γ, come i raggi X, privi di massa, sono molto penetranti e possono essere schermati, anche se non del tutto, da lastre di piombo spesse parecchi centimetri o da barriere di cemento spesse parecchi decimetri. Alcuni elementi, come l’uranio e il radio, quest’ultimo scoperto dai coniugi Curie, si dimostrano particolarmente attivi nell’emissione delle suddette radiazioni.

Modelli

atomici

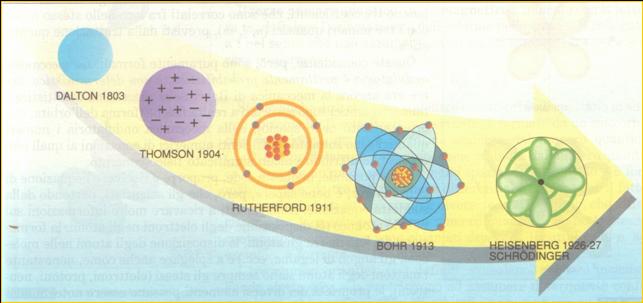

Con il susseguirsi delle scoperte elencate precedentemente si formularono vari tipi di modelli atomici:

Si comincia, così seriamente ad immaginare l’atomo, costituente fondamentale della materia ed elettricamente neutro, come formato da particelle positive e negative.

Nel 1904 Thomson, nel saggio On the Structure of the atom, propone per la struttura dell’atomo un modello che riscuote un buon successo. Egli, in base ai dati sperimentali e alle teorie al momento disponibili, ritiene che gli elettroni, negativi, debbano essere come affogati in una sfera diffusa di elettricità positiva, che li attrae e rende possibile una loro presenza ravvicinata (gli elettroni, tutti carichi negativamente, tenderebbero a respingersi l’un l’altro). Gli elettroni di questo modello si possono immaginare come acini di uvetta disseminati nell’interno di un panettone: il modello ‘a panettone’.

Questo modello ebbe vita breve, perché venne presto messo in crisi dalle nuove conoscenze acquisite dagli esperimenti di Rutherford.

Il

modello atomico di Rutherford (1911)

Un modello senz’altro più attuale è proprio quello di Rutherford. Rutherford nel laboratorio di Manchester aveva studiato con molto impegno i fenomeni di radioattività e, con la preziosa collaborazione di H. Geiger e E. Marsden, aveva analizzato lo scattering (‘diffusione’) di particelle α su lamine d’oro.

Le particelle α, positive, riuscivano a passare quasi tutte (oltre il 99%) indisturbate attraverso una sottile lamina d’oro; le altre venivano più i meno deviate, anche di angoli considerevoli; qualcuna, addirittura, veniva riflessa sul suo cammino.

<<

Fu il fatto più incredibile che mi sia mai capitato nella vita. Altrettanto

incredibile che, se aveste sparato un proiettile da 15 pollici su un foglio di

carta, questo fosse tornato indietro a colpirvi…>>- I risultati

sperimentali, infatti non sono in alcun modo comprensibili se si rimane fedeli

al modello di Thomson che prevede per l’atomo una struttura essenzialmente

omogenea, poco differenziata. Le particelle α

dovevano o passare tutte o essere respinte tutte alla stessa maniera.

Rutherford riesce a ricavare dagli esperimenti effettuati le seguenti conclusioni:

1. Le particelle α, che hanno una massa circa 7500 volte maggiore da quella di un elettrone, per passare indisturbate non devono trovare ostacolo nelle masse dei singoli atomi d’oro, che devono essere concentrate in regioni particolari dette nuclei.

2.

Il nucleo è 104 -105 volte più piccolo

dell’atomo ed è carico positivamente. Solo regioni nucleari così ristrette,

e positive, possono spiegare la deviazione a grandi angoli di un numero limitato

di particelle α.

3. Gli elettroni impiegano, comunque, in qualche modo, l a periferia atomica, dal momento che la materia è, in condizioni ordinarie, impenetrabile. In prima approssimazione gli elettroni possono essere immaginati come i pianeti attorno al Sole: è grazie al loro vorticoso movimento che riescono a presidiare efficacemente la zona perinucleare.

4. il numero degli elettroni, negativi, è esattamente uguale a quello dei protoni, positivi, per cui l’atomo nel suo complesso è neutro. Il numero dei protoni è detto numero atomico. I neutroni, così chiamati perché non hanno carica elettrica, furono scoperti nel 1932; hanno massa quasi uguale a quella dei protoni: sono collocati, con i protoni, nel nucleo. Il numero dei protoni addizionato al numero dei neutroni dà il numero di massa. Gli atomi di uno stesso elemento hanno sempre per il numero atomico, ma possono differire per il numero di massa.

Il modello planetario o nucleare, proposto da Rutherford, pur seducendo per la sua semplicità, si dimostrerà, però, ben presto insufficiente. Gli elettroni, muovendosi attorno al nucleo, avrebbero dovuto emettere energia. Questo comportavano le leggi della fisica classica e dell’elettromagnetismo, che giustificano, fra l’altro, la possibilità di realizzare trasmissioni radio. Una carica elettrica, ogni qual volta sia accelerata, irradia energia elettromagnetica. Gli elettroni, per ruotare attorno al nucleo, devono avere costantemente accelerazione centripeta. Gli elettroni, perdendo energia, dovrebbero, così, avvicinarsi progressivamente al nucleo e cadere su di esso: il tutto nel tempo brevissimo di 10-8 secondi.

Il giovane danese N. Bohr (1885- 1962), che da poco era stato accettato da Rutherford nel suo gruppo di ricerca di Manchester, pubblica nel 1913 la memoria On the Costitution of Atoms and Molecules: non vuole abbandonare del tutto il modello planetario, è ben convinto che la meccanica e l’elettromagnetismo classici non possono essere applicati al mondo atomico e , soprattutto, sa utilizzare bene la teoria quantistica proposta da M. Planck nel 1900.

Il

modello atomico quantistico di Bohr (1913)

Le regolarissime righe emesse dell’idrogeno una volta eccitato suggerirono a Bohr la possibilità di applicare la teoria di Planck per interpretare, allo stesso tempo, le modalità di produzione delle righe e la struttura dell’atomo d’idrogeno. Le righe spettrali emesse dagli atomi dei diversi elementi vennero intese dal fisico danese come segnali del contenuto energetico degli elettroni in essi presenti. La costanza delle righe e la loro elevata specificità non potevano essere casuali e di poco conto, ma inerenti all’intima struttura degli stessi atomi. L’analisi dettagliata condotta da Bohr si concluse con la proposizione di un nuovo modello atomico, che è stato giustamente definito quantistico.

I punti qualificanti del nuovo modello sono i seguenti:

1. Un atomo può esistere solo in determinati stati stazionari (o quantici) corrispondenti a determinati valori della sua energia. In tali stati gli elettroni non irraggiano e , quindi, non perdono energia, non precipitando sul nucleo.

2. L’irraggiamento (o, al contrario, l’assorbimento di energia) è causato solo dalla transizione da uno stato a un altro di energia più bassa (o più elevata, nel caso dell’assorbimento).

3. L’elettrone descrive orbite circolari i cui raggi dipendono direttamente da n2; n è chiamato primo numero quantico o numero quantico principale.

4. L’energia posseduta dall’elettrone , che descrive una determinata orbita è inversamente proporzionale a n2.

5. Se si fornisce energia all’elettrone in quantità sufficiente è possibile farlo saltare da un’orbita all’altra. L’elettrone carico negativamente, utilizza energia acquisita per vincere la forza attrattiva che lo lega al nucleo, carico positivamente. Quando ritorna allo stato stazionario di partenza, l’elettrone restituisce energia, prima assorbita, sotto forma di radiazione con una determinata frequenza. È rispettata l’equazione:

E2

– E1 = ∆E = h

* v

In cui ∆E indica la differenza di energia fra i due stati; ricavando la frequenza si ha:

![]()

Il

modello atomico quantistico- ondulatorio

Il modello di Bohr venne perfezionato nel 1916 dal fisico tedesco A. J. W. Sommerfeld (1868- 1951) soprattutto per spiegare la struttura delle righe spettrali. Queste, infatti, osservate con strumenti capaci di elevato potere di risoluzione, si dimostravano, in parte, costituite da più righe ravvicinate. Sommerfeld dimostrò,così, che gli stati effettivi dell’atomo d’idrogeno devono essere caratterizzati non solo dal numero quantico principale n, ma anche da altri due numeri quantici: azimutale (l) e magnetico (m).

Un notevole perfezionamento del modello di Bohr si ebbe solo qualche anno dopo, quando si cominciò a proporre e a valutare la natura ondulatoria degli elettroni.

È il fisico francese L. de Broglie (1892- 1987) che per primo, nel 1923, propose di attribuire alle particelle materiali, e quindi agli elettroni, anche proprietà ondulatorie, eguagliando l’equazione di Planck (E = h * v) con l’equazione di Einstein (E = m * c2)possiamo scrivere:

E

= m * c2 = h * v

Tenendo conto della velocità effettiva delle particelle e ricordando che, in generale,

ottenendo:

![]()

La formula di de Broglie attribuisce una natura ondulatoria a qualsiasi corpo. Anche al nostro corpo è associata un’onda. Esso, però, ha una massa notevole e la lunghezza della sua onda è così piccola che le caratteristiche ondulatorie del nostro corpo non sono ‘di fatto’ rilevabili. L’elettrone, invece, ha una massa sufficientemente piccola da poter manifestarsi come onda. Un fascio di elettroni subisce ad esempio, la diffrazione allo stesso modo di un fascio di luce.

Qui verrebbe da porsi la domanda sulla vera natura dei microcorpi: si comportano come corpuscoli o come onde? A questa domanda trova una prima risposta Bohr, ma in modo più considerevole la trova nel 1927 il giovane fisico tedesco W. Heisenberg (1901- 1976) riuscendo ad esprimere quantitativamente quanto sosteneva Bohr nel principio d’indeterminazione: <<è impossibile conoscere contemporaneamente sia l’esatta posizione che l’esatta velocità di una particella elementare>>. La natura ondulatoria di particelle come gli elettroni comporta un’intrinseca difficoltà a localizzarle, a definire la loro posizione nello spazio, senza perturbarle.

Lo scienziato impegnato nello studio della struttura submicroscopica dell’atomo viene a trovarsi nella stessa situazione di un tennista che viene privato della sua racchetta e obbligato a utilizzare una pala meccanica per rilanciare la pallina: nei tentativi di conseguire il risultato, il rischio di travolgere rete, avversario ed eventuali spettatori non è di poco conto. L’unica differenza è che nella realtà non si può sperare in un affinamento tecnologico come potrebbe accadere nell’esempio riportato; ciò è dimostrato da Heisenberg con un rigoroso procedimento matematico.

Nel 1926 il fisico austriaco E. Schrodinger (1887- 1916), sviluppando ulteriormente il pensiero di de Broglie, ha costruito una particolare meccanica ondulatoria, fondata su un’equazione nella quale vengono attribuite contemporaneamente all’elettrone la natura di un’onda e la natura di una particella (equazione d’onda).

Risolvendo l’equazione d’onda di un particolare stato quantico (definito dai numeri quantici n, l, m) attorno ad un atomo, si ottiene una funzione d’onda. Non è possibile attribuire un significato fisico concreto a tale funzione; il suo quadrato invece è proporzionale alla probabilità di trovare l’elettrone in un punto dello spazio. La rappresentazione grafica di questa funzione elevata al quadrato appare come una nuvola diffusa di probabilità, diversa per ogni stato quantico. Di questa nuvola si utilizzano comunemente le superfici a densità elettronica costante, indicate con il termine di orbitali. Un orbitale rappresenta la regione dello spazio che racchiude il 90 % di probabilità di trovare un determinato elettrone: l’elettrone diventa, nel modello quantistico- ondulatorio, una nube diffusa di carica negativa dai contorni sfumati, che è contenuta al 90 % nello spazio definito dall’orbitale.

La meccanica ondulatoria è prettamente probabilistica, e non deterministica, come era ancora la meccanica di Bohr;nella meccanica quantistica i numeri quantici sono associati a realtà fisiche; nella meccanica ondulatoria i numeri quantici sono soltanto coefficienti numerici di equazioni ai quali non è possibile attribuire alcun significato concreto.

Le

particelle elementari

La storia della scoperta della particelle elementare successiva a quelle individuate quando si formularono i primi modelli atomici è lunga e complicata. Cominciò nel 1935 con una proposta di Hideki Yukawa secondo la quale in un nucleo i protoni e i neutroni sono tenuti insieme da un campo, allo stesso modo con cui in un atomo il nucleo e l’elettrone sono legati tramite il campo elettromagnetico. Yukawa sottolineò che le piccole dimensioni del nucleo implicano che il raggio d’azione delle forze nucleari sia piccolo, la qual cosa è a sua volta da collegarsi al fatto che il campo trasporta una grande quantità di moto. Ora, per i principi della relatività ristretta, la quantità di moto media del campo è dell’ordine della velocità della luce moltiplicata per la massa del quanto associato al campo. Dalle dimensioni dei nuclei, Yukawa così concluse che questa massa è all’incirca 200 volte la massa dell’elettrone. Egli osservò poi: “ Poiché un quanto con massa così grande non è mai stato trovato sperimentalmente, sembra che la suddetta teoria sia errata. “ Yukawa non sapeva che proprio allora C. D. Anderson e S. H. Neddermeryer stavano effettuando ricerche sulla capacità delle particelle cariche dei raggi cosmici di attraversare la materia. Le ricerche furono molto laboriose,perché occorse parecchio tempo per raccogliere sufficienti dati sperimentali. Inoltre gli esperimenti furono resi difficili dalla circostanza che i fenomeni osservati nei raggi cosmici erano del tutto nuovi per i fisici, e perciò non era ancora stabilito in modo sicuro un metodo di studio di questi fenomeni. Quando si verificava qualcosa di strano, inatteso, non era chiaro se erano implicate nuove particelle e (oppure) nuovi principi, oppure se le vecchie particelle e i vecchi principi stavano manifestando un nuovo sorprendente comportamento in un nuovo campo di ricerca. Anderson e Neddermeyer perseveravano nonostante queste difficoltà e negli anni 1934, 1935 e 1936 pervennero, con indagini molto accurate, alle conclusioni che nei raggi cosmici erano presenti nuovi tipi di particelle, cariche alcune positivamente, altre negativamente. Queste particelle avevano una massa intermedia tra le masse dell’elettrone e del protone e venne naturale concluderne che esse erano le particelle di cui Yukawa aveva previsto l’esistenza e che servono a trasmettere le forze nucleari. Esse furono dapprincipio chiamate mesotroni e più tardi mesoni.

Tuttavia il travaglio per la nascita di queste nuove particelle non era ancora finito, poiché varie misurazioni della massa dei mesoni diedero risultati del tutto differenti. Si fecero grandi sforzi per misurare con maggior precisione la massa e per analizzare teoricamente con più cura i dati, ma la prima indicazione definitiva che si doveva trattare di qualcosa di più complesso venne dal lavoro di Marcello Conversi, Ettore Pancini e Oreste Piccioni concernente lo studio delle interazioni tra i mesoni dei raggi cosmici e i nuclei atomici. Il loro esperimento, pubblicato nel 1947, mostrò che questa interazione era estremamente debole. Fu allora sottolineato da Enrico Fermi, Edward Teller e V. F. Weisskopf che c’era qualcosa che non andava affatto, poiché queste particelle, che interagiscono così poco coi nuclei, non potevano trasmettere le intensissime forze nucleari. Di fatto essi dimostrarono che i mesoni dei raggi cosmici potrebbero servire solo come intermediari di forze, che sono più deboli delle forze nucleari di un fattore di almeno 1018. Questa grande discrepanza portò a speculazione teoriche molto interessanti. In particolare S. Sakata e T. Inoue, H. A. Bethe e R. E. Marshak avanzarono l’ipotesi che i mesoni dei raggi cosmici fino allora osservati non fossero i mesoni di Yukawa. Anche questi ultimi dovevano essere pesanti nei raggi cosmici, ma la loro vita non doveva essere lunga abbastanza da consentire l’osservazione con i dispositivi sperimentali allora esistenti. La soluzione finale del problema venne nel seguente modo.

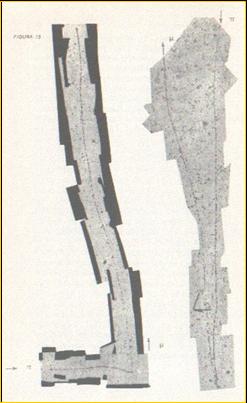

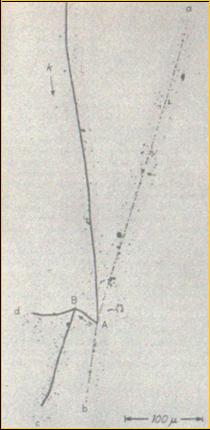

Press’a poco in quel tempo a Bristol C. F. Powell e il suo gruppo avevano sviluppato la tecnica delle emulsioni fotografiche per rilevare particelle cariche. Gli ioni prodotti nelle emulsioni delle cariche, lungo il loro cammino fanno apparire, dopo lo sviluppo, dei granuli neri. Questi granuli segnano le tracce o i cammini di particelle cariche attraverso l’emulsione. Powell e i suoi collaboratori esaminarono le tracce lasciate sulla lastra fotografica da alcune delle particelle cariche dei raggi cosmici.

La

figura qui affianco mostra due tracce caratterizzate dalla variazione della

densità dei grani lungo una traccia e dallo scostamento di una traccia rispetto

alla linea retta, dovuto alla deviazione della particella nell’attraversare

l’emulsione, è possibile ottenere un numero d’informazioni sulla particella

stessa. Per esempio, quando una particella rallenta, ionizza di più e perciò i

grani lungo la traccia infittiscono. Per il tracciato più a sinistra

l’interpretazione è pertanto questa: è arrivata una particella da sinistra

in basso, ha rallentato e si è fermata nell’angolo in basso a destra, si è

disintegrata in alcune particelle neutre che non hanno lasciato traccia e in una

particella carica che è andata verso l’alto, ha rallentato di nuovo ed è

uscita dalla regione osservata. L’altra traccia presenta un caso molto simile.

Questi due casi particolari furono proprio i primi due pubblicati dal gruppo di

Powell, concernenti mesoni fermati che davano luogo a una traccia mesonica

secondaria. Essi chiamarono i mesoni primari e secondari mesoni π e mesoni

μ. Più tardi si poté disporre di una emulsione fotografica più sensibile

e si trovò che un mesone μ,

se si fermava l’emulsione, dava luogo a una traccia leggerissima, che fu

identificata con quella di un elettone. L’intero processo fu spiegato così:

La

figura qui affianco mostra due tracce caratterizzate dalla variazione della

densità dei grani lungo una traccia e dallo scostamento di una traccia rispetto

alla linea retta, dovuto alla deviazione della particella nell’attraversare

l’emulsione, è possibile ottenere un numero d’informazioni sulla particella

stessa. Per esempio, quando una particella rallenta, ionizza di più e perciò i

grani lungo la traccia infittiscono. Per il tracciato più a sinistra

l’interpretazione è pertanto questa: è arrivata una particella da sinistra

in basso, ha rallentato e si è fermata nell’angolo in basso a destra, si è

disintegrata in alcune particelle neutre che non hanno lasciato traccia e in una

particella carica che è andata verso l’alto, ha rallentato di nuovo ed è

uscita dalla regione osservata. L’altra traccia presenta un caso molto simile.

Questi due casi particolari furono proprio i primi due pubblicati dal gruppo di

Powell, concernenti mesoni fermati che davano luogo a una traccia mesonica

secondaria. Essi chiamarono i mesoni primari e secondari mesoni π e mesoni

μ. Più tardi si poté disporre di una emulsione fotografica più sensibile

e si trovò che un mesone μ,

se si fermava l’emulsione, dava luogo a una traccia leggerissima, che fu

identificata con quella di un elettone. L’intero processo fu spiegato così:

π+ → μ- + υ

μ+

→ e+ + υ + -υ

i neutrini (υ)

e gli antineutrini (-υ),

essendo neutri, non lasciano tracce visibili. La loro presenza in queste

disintegrazioni fu ricavata da studi particolareggiati sui bilanci di energia,

quantità di moto e momento angolare. I mesoni π e

μ

carichi negativamente si disintegrano in maniere analoghe. Da questi studi

particolareggiati si ottennero anche le masse dei mesoni π

e μ.

Esse sono rispettivamente 273 e 207 volte la massa dell’elettrone.

La scoperta dell’esistenza di due tipi di mesoni eliminò la discrepanza

di cui abbiamo parlato prima. Il mesone π

è identificato col mesone di cui parlava Yukawa e serve da intermediario per le

forze nucleari, mentre il suo discendente, il mesone μ,

è il mesone dei raggi cosmici osservato da Conversi, Pacini e Piccioni che non

interagisce fortemente con i nuclei atomici.

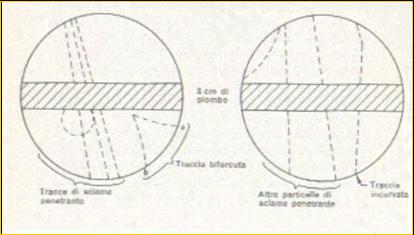

Le cose andarono ulteriormente complicandosi quando nel 1947 a Manchester G.

D. Rochester e C. C. Butler ricavarono da un grande numero di fotografie in

camere a nebbia di particelle di sciami penetranti di raggi cosmici.

Nello schema di sinistra sono rappresentate le tracce a e b dovute ai

prodotti di disintegrazione carichi dovute dalla disintegrazione di una

particella neutra di massa uguale a circa 1000 masse elettroniche, valore

diverso da quello delle masse di tutte le particelle fino allora conosciute.

Dallo schema di destra conclusero che la traccia curva rappresentava la

disintegrazione di una particella carica (di massa circa 1000 masse

elettroniche) in una particella neutra e una particella secondaria carica. Due

anni più tardi, nel 1949, usando la nuova tecnica delle emulsioni fotografiche,

Powell e i suoi collaboratori ottennero

la fotografia

di una

particella di un raggio cosmico.

Nello schema di sinistra sono rappresentate le tracce a e b dovute ai

prodotti di disintegrazione carichi dovute dalla disintegrazione di una

particella neutra di massa uguale a circa 1000 masse elettroniche, valore

diverso da quello delle masse di tutte le particelle fino allora conosciute.

Dallo schema di destra conclusero che la traccia curva rappresentava la

disintegrazione di una particella carica (di massa circa 1000 masse

elettroniche) in una particella neutra e una particella secondaria carica. Due

anni più tardi, nel 1949, usando la nuova tecnica delle emulsioni fotografiche,

Powell e i suoi collaboratori ottennero

la fotografia

di una

particella di un raggio cosmico.

Essi interpretarono il processo come dovuto a una ‘particella k’, che si arresta nel punto A e

si disintegra in tre mesoni: Aa , Ab e AB. L’ultimo di questi provoca nel

punto B una disintegrazione nucleare. Sia lo schema di disintegrazione che la

massa della particella primario k non si adattavano ad alcuna delle particelle

conosciute a quel tempo. Powell e il suo gruppo chiamarono questa nuova

particella mesone τ, ora chiamata mesone k o kaone.

Queste tre fotografie ci hanno permesso di gettare un primo sguardo nel

mondo del tutto imprevisto e complesso delle particelle nuove. Poiché tali

particelle giungevano inattese, si diede loro il nome collettivo di

“particelle strane”. Esse sono generate in collisioni in cui sono in gioco

energie di più di un milione di elettronvolt (Unità di misura per

l'energia, definita come l'energia acquistata da un elettrone accelerato da una

differenza di potenziale di un volt.).

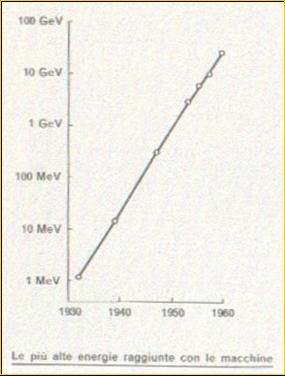

Negli abbi dal 1948 al 1953 l’unica sorgente disponibile di energie cos’

elevate erano i raggi cosmici, ma essi non sono una sorgente controllabile di

particelle di energia elevata; inoltre la frequenza con cui s’incontrano

particelle cosmiche di alta energia in strumenti di dimensioni normali è molto

piccola. Fortunatamente, grazie al rapido sviluppo della tecnologia e

dell’arte di costruire macchine ad alta energia, diventò possibile diventò

possibile in quel periodo costruire strumenti nel dominio del miliardo di

elettronvolt.

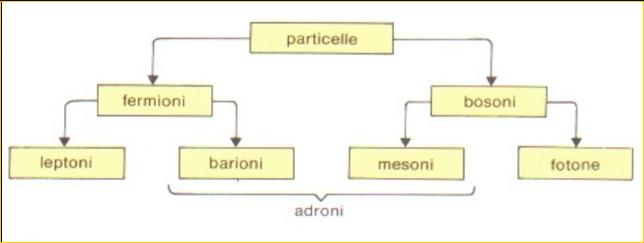

Esistono tre principali famiglie di particelle: i barioni (le più pesanti)

formano la prima, i leptoni (le più leggere)

formano la seconda, infine i mesoni formano la terza (di massa intermedia). I

barioni e mesoni formano insieme la famiglia degli adroni.

Tutte le particelle subnucleari sono classificabili in due grandi gruppi, a

seconda del loro comportamento statistico in meccanica quantistica. Così come i

protoni e i neutroni nel nucleo e gli elettroni nell’atomo, esse sono

descritte da una funzione d’onda che ne rappresenta l’evoluzione nello

spazio e nel tempo. Se questa funzione è antisimmetrica, cioè se cambia segno

scambiando due qualunque delle particelle del sistema l’una con l’altra,

allora le particelle seguono la statistica di Fermi- Dirac. Questa prevede che

due o più particelle con gli stessi numeri quantici non possono coesistere

nello stesso sistema, motivo per cui uno stato quantico può essere occupato al

più da una particella. Le particelle che sono soggette a questa condizione,

detta principio d’esclusione di Pauli, sono collettivamente chiamate fermioni.

Esistono tre principali famiglie di particelle: i barioni (le più pesanti)

formano la prima, i leptoni (le più leggere)

formano la seconda, infine i mesoni formano la terza (di massa intermedia). I

barioni e mesoni formano insieme la famiglia degli adroni.

Tutte le particelle subnucleari sono classificabili in due grandi gruppi, a

seconda del loro comportamento statistico in meccanica quantistica. Così come i

protoni e i neutroni nel nucleo e gli elettroni nell’atomo, esse sono

descritte da una funzione d’onda che ne rappresenta l’evoluzione nello

spazio e nel tempo. Se questa funzione è antisimmetrica, cioè se cambia segno

scambiando due qualunque delle particelle del sistema l’una con l’altra,

allora le particelle seguono la statistica di Fermi- Dirac. Questa prevede che

due o più particelle con gli stessi numeri quantici non possono coesistere

nello stesso sistema, motivo per cui uno stato quantico può essere occupato al

più da una particella. Le particelle che sono soggette a questa condizione,

detta principio d’esclusione di Pauli, sono collettivamente chiamate fermioni.

Se invece la funzione è simmetrica, allora le particelle che compongono il

sistema seguono la statistica di Bose- Einstein, in base alla quale non c’è

limite al numero di particelle che possono occupare lo stesso stato quantico.

Queste particelle sono collettivamente chiamate bosoni.

Però nel 1964 Murray Gell-Mann e George Zweig ipotizzarono che tutte le particelle note all'epoca potessero venire spiegate come combinazioni di 3 sole particelle fondamentali. Gell-Mann scelse per questi costituenti elementari il nome stravagante di quark. E' una parola di una frase del romanzo Finnegan's Wake di James Joyce: "three quarks for Muster Mark" (con quark s’intendeva qu(estion) (m)ark).

A differenza dell'elettrone, appartenente ai leptoni, il

protone ed il neutrone, le altre due particelle componenti l'atomo, non sono,

diversamente da quanto si potrebbe credere, particelle elementari. Questi

appartengono infatti alla famiglia degli adroni. Sono state catalogate centinaia di

specie di adroni variabili per massa, spin, carica e altre proprietà. Nel 1964

Murray Gell-Mann, del California Institute of Technology (Caltech) e George

Zweig, allora al CERN di Ginevra, cercarono, indipendentemente l'uno dall'altro,

una spiegazione alla enorme quantità di diverse specie di adroni. Venne allora

correttamente ipotizzato che questi non fossero particelle elementari come

allora si credeva, ma composti di più costituenti.

La conferma venne sul finire degli anni Sessanta, presso lo Stanford Linear

Accelerator Center (SLAC). Qui elettroni ad alta energia venivano sparati ad

altissime velocità contro protoni e neutroni. Dalla distribuzione angolare ed

energetica degli elettroni risultò evidente che questi si scontravano contro

particelle elettricamente cariche contenute all'interno dei due adroni.

Così come per i leptoni, anche i Quark conosciuti sono in tutto sei e sono

stati suddivisi in tre famiglie:

Per i quark la prima generazione e' formata da up (u) e down (d), la seconda da charm (c) e strange (s) la terza da top (t) e bottom (d), dove il primo dei due ha sempre carica 2/3 e il secondo -1/3. Così come i leptoni, i Quark hanno spin 1/2 e possono dunque essere sia sinistrorsi che destrorsi. Per quanto riguarda le cariche elettriche, ognuno, come si può notare, porta una carica pari ad una frazione esatta dell'energia dell'elettrone; i relativi antiquark hanno la stessa carica, ma di segno opposto. Ma poiché ogni particella deve avere carica elettrica multipla intera della carica elementare e dell'elettrone, i Quark non possono mai essere osservati isolati, ma sempre raggruppati. Questa proprietà prende il nome di 'schiavitù asintotica'. Secondo la QCD (Quantum CromoDinamic, in italiano Cromodinamica Quantistica), i quark possono essere raggruppati solamente in due modi:

![]()

e vanno a formare i mesoni.

![]()

e vanno a formare i barioni.

Similmente ai leptoni, i quark sono soggetti alle interazioni deboli che

cambiano una specie in un altra. Per esempio, nel decadimento β di

un protone in un neutrone uno dei quark d del neutrone si trasforma in un

quark u, emettendo nel corso del processo un elettrone e un antineutrino.

In evidente contrasto con il comportamento dei leptoni, alcuni decadimenti di

quark violano però le regole della parentela; sono state osservate

trasformazioni di quark u in quark s e di quark c in quark d.

E' stata la somiglianza delle due famiglie note di quark con le famiglie dei

leptoni a suggerire per la prima volta l'esistenza di un quark t, con la

funzione di partner del quark b in una terza famiglia. Diversamente dai

leptoni, non sono mai stati osservati quark liberi. Eppure le prove

circostanziate della loro esistenza sono aumentate costantemente. Un'indicazione

della validità del modello a quark è il suo successo nel prevedere prodotti di

collisioni ad alta energia tra un elettrone e un positrone. Dal momento che

rappresentano materia e antimateria, le due particelle si annichilano a vicenda

liberando energia sotto forma di un fotone. Il modello a quark prevede che

l'energia di un fotone si possa materializzare in un quark e in un antiquark.

Dato che la coppia elettrone-positrone in collisione aveva una quantità di moto

totale nulla, la coppia quark-antiquark deve divergere in direzioni opposte con

la stessa velocità in modo che la sua quantità di moto totale sia ancora

nulla. I quark passano però inosservati perché la loro energia viene

convertita in altri quark e antiquark che si materializzano e si combinano con

la coppia originaria, dando origine a due getti di adroni (per la maggior parte

pioni). Tali getti vengono realmente osservati e il fatto che siano focalizzati

conferma che gli adroni non nascono direttamente dalla collisione, ma da singole

particelle indivisibili delle quali i getti mantengono le traiettorie. La realtà

dei quark è inoltre confermata dalla varietà di livelli energetici, o masse,

ai quali si possono osservare, in esperimenti con gli acceleratori, certe specie

di adroni. Tali spettri energetici sembrano simili agli spettri atomici: pare

che essi rappresentino gli stati quantici di un sistema legato, formato

da due componenti più piccoli. Ognuno di questi stati quantici rappresenterebbe

un diverso grado di eccitazione e una diversa combinazione degli spin e del moto

orbitale dei componenti. Per la maggior parte dei fisici risulta inevitabile la

conclusione che tali particelle siano costituite di quark.

Nell’universo esistono 4 forze le quali sono trasmesse da altrettante particelle.

Il campo elettromagnetico è costituito da fotoni scoperti osservando la luce. L’interazione elettromagnetica

è responsabile della struttura atomica e molecolare, delle reazioni chimiche e

di tutte le forze (escluse quelle gravitazionali) che osserviamo nel nostro

mondo (come, ad esempio, le forze magnetiche). Si manifesta tra tutte le

particelle elettricamente cariche. Oggi si sa che le diverse forme di energie

raggiante, tra cui appunto la luce e per esempio le onde radio o le microonde,

si trasmettono appunto attraverso onde elettromagnetiche. Tuttavia, alcuni dati

sperimentali ottenuti verso la fine dell'Ottocento non potevano essere spiegati

pensandola come onda. Con la ideazione della meccanica quantistica si pensò di

trattare gli effetti della radiazione elettromagnetica e quindi dello scambio di

energia nelle particelle come se fossero portati da delle particelle. Tra gli

esperimenti inspiegabili qualora si pensi alla luce come ad un'onda luminosa, vi

era l'effetto fotoelettrico. Nel

1905 Albert Einstein riuscì a spiegarlo, supponendo che la luce fosse composta

di corpuscoli elementari, i "quanti di energia" o fotoni

e che questi, nei loro urti con gli atomi, trasmettessero agli elettroni

periferici un'energia tale da provocarne l'emissione ed il conseguente effetto

fotoelettrico. L’energia di un fotone non è continua, ma è proporzionale

alla frequenza della radiazione elettromagnetica a cui appartiene, secondo la

formula scoperta da Planck.

Il campo gravitazionale è costituito da gravitoni che sono particelle elementari la cui esistenza è supposta teoricamente, come quanto del campo gravitazionale. Secondo la teoria della relatività generale di A. Einstein e la teoria quantistica ogni massa accelerata emette un'onda gravitazionale e perciò è sorgente di un campo di radiazioni: in accordo con la teoria quantistica dei campi dovrebbe manifestarsi sotto forma di particelle, i supposti gravitoni, in analogia ai fotoni del campo elettromagnetico. Esse dovrebbero avere spin pari a 2, carica e massa nulla e quindi bosoni. Sperimentalmente la radiazione gravitazionale non è stata ancora osservata, poiché il processo d'interazione tra materia e radiazione gravitazionale è debolissimo (circa 10-39 volte la forza coulombiana) ed è quindi molto difficile porlo in evidenza.

L’interazione nucleare forte è mediata dal gluoni che è un ipotetico quanto responsabile della trasformazione di colore dei quark. È responsabile della struttura degli adroni e dei nuclei, permettendo a questi di rimanere legati, vincendo la repulsione coulombiana tra i protoni. Si manifesta a livello fondamentale tra quarks e gluoni. Secondo le recenti scoperte sperimentali fatte nel campo della fisica subnuleare le particelle che presentano un'interazione forte, come per esempio i nucleoni, sono costituite da combinazioni di quark. Questi sono tenuti insieme da forze che vengono mediate da quanti (della cui esistenza si hanno prove sperimentali indirette) detti appunto gluoni, in analogia per esempio con i fotoni che mediano le forze elettromagnetiche tra le particelle cariche.

L’interazione nucleare debole ha un raggio d’azione brevissimo (inferiore a 10-15 m), ma si realizza in una scala temporale molto varia ( da 10-10 s a 103 s). Questa interazione condiziona la scala temporale dei processi nucleari all’interno delle stelle (se questa forza venisse a mancare, il sole esploderebbe immediatamente come una gigantesca bomba termonucleare). è responsabile dei decadimenti delle particelle e dei decadimenti β dei nuclei. Si manifesta tra tutte le particelle, leptoni e quarks. Queste interazioni hanno tre bosoni intermedi, detti Z0, W+, W-; tra tutti i bosoni intermedi questi sono gli unici a non avere massa nulla. Quest’ultima interazione e quella elettromagnetica successivamente si sono potute considerare come manifestazioni di un’unica interazione detta elettrodebole.

|

LEPTONI |

|

|

|

|

nome della particella |

simbolo |

massa di riposo (MeV/c2) |

carica elettrica |

|

neutrino elettronico |

ne |

circa 0 |

0 |

|

elettrone |

e- |

0,511 |

-1 |

|

neutrino muonico |

nm |

circa 0 |

0 |

|

muone |

m- |

106,6 |

-1 |

|

neutrino tauonico |

nt |

meno di 164 |

0 |

|

tau |

t- |

1784 |

-1 |

|

QUARK |

|

|

|

|

nome della particella |

simbolo |

massa di riposo (MeV/c2) |

carica elettrica |

|

|

u |

310 |

2/3 |

|

|

d |

310 |

-1/3 |

|

|

c |

1500 |

2/3 |

|

|

s |

505 |

-1/3 |

|

|

t |

172000 |

2/3 |

|

|

b |

5000 |

-1/3 |

|

forza |

raggio d'azione |

portatore |

massa di riposo (GeV/c2) |

spin |

carica elettrica |

note |

||||||||||||

|

gravità |

infinito |

gravitone |

0 |

2 |

0 |

ipotizzato |

||||||||||||

|

elettromagnetismo |

infinito |

fotone |

0 |

1 |

0 |

osservato

direttamente |

||||||||||||

|

debole |

meno

di 10-16 centimetri |

|

|

|

|

osservati

direttamente |

||||||||||||

|

forte |

meno

di 10-13 centimetri |

gluoni |

0 |

1 |

0 |

confinato

permanentemente |

Il

maggior campo di ricerca attuale della fisica delle particelle

"Noi pensiamo che vi sia uno spettro che si aggira per l'universo, che ci

impedisce di capire la reale natura della materia. E' come se qualcosa, o

qualcuno, volesse precluderci il raggiungimento della conoscenza definitiva. La

barriera invisibile che ci impedisce di conoscere la verità si chiama

"campo di Higgs". I suoi gelidi tentacoli si estendono in ogni angolo

dell'universo e le sue implicazioni scientifiche e filosofiche producono dei

grossi bernoccoli sulla testa dei fisici. Il campo di Higgs compie le sue

stregonerie mediante una particella. Questa va sotto il nome di "particella

di Higgs".

Leon Lederman, premio Nobel 1988 per la Fisica

Dalle galassie agli esseri viventi all'atomo, tutta la materia ha una massa. La legge di gravitazione universale scoperta da Isaac Newton fece capire che la massa ha un ruolo fondamentale nelle leggi dell'universo. Einstein dimostrò che la stessa può essere trasformata in energia, ma nessuno finora ha saputo spiegare in termini scientifici cosa sia veramente la massa. Ogni elemento ha una dimensione, che esiste proprio perché le particelle fondamentali di cui è costituito hanno una certa massa. Se gli elettroni avessero una massa maggiore di quella che hanno, le loro orbite sarebbero minori, di conseguenza l'atomo, e quindi tutto, sarebbe più piccolo. Se al contrario negli elettroni non avessero affatto massa, l'esistenza di qualsiasi materiale sarebbe impossibile. La questione della massa è dunque di fondamentale importanza per la conoscenza dell'universo, ma è anche uno degli enigmi ancora irrisolti della fisica. Scoprire cosa dà la massa alle particelle e quindi cosa "crea" la materia sensibile significa dimostrare l'esistenza della particella in assoluto ad oggi più inafferrabile: la particella di Higgs. Secondo la fisica quantistica, il vuoto non è in realtà vuoto ma permeato di invisibili particelle passeggere, che appaiono e scompaiono costantemente. I fisici delle alte energie descrivono questo fenomeno come un campo, il "Campo di Higgs", che pervade tutto lo spazio ed ingombra il vuoto rendendo "pesante" la materia. Si ipotizza infatti che attraverso l'interazione con il campo di Higgs tutte le altre particelle acquistino la loro massa. Maggiore è l'intensità dell'interazione, maggiore è la massa. Essendo un campo sempre associato alla sua particella, trovare la particella di Higgs significa avere la conferma dell'esistenza del campo omonimo.

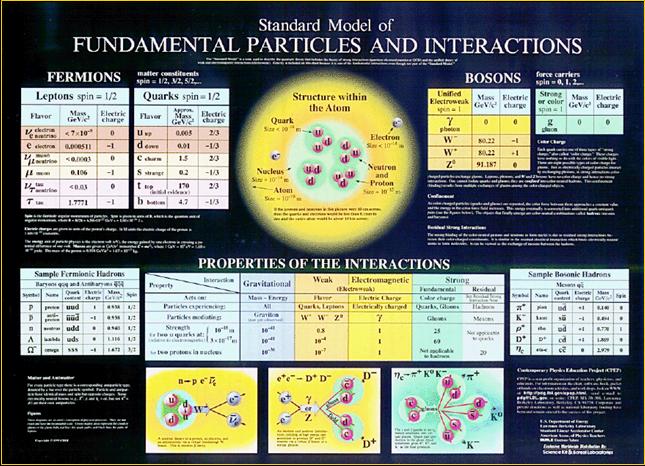

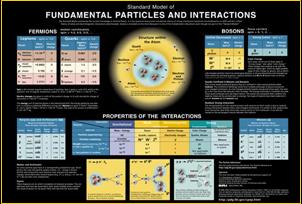

Tutte

le conoscenze acquisite dalla fisica negli ultimi quarant'anni sono condensate

in quello che gli scienziati chiamano "Modello Standard", la

spiegazione più esauriente delle particelle fondamentali e delle loro

interazioni. Il Modello riesce a spiegare tutti i tipi osservabili di materia,

che è composta solo da dodici particelle base: sei tipi di quark e sei tipi di

leptoni, raggruppati in tre famiglie. Spiega inoltre le possibili interazioni

tra queste particelle e le quattro forze fondamentali. Sono stati necessari

oltre trent'anni di sforzi teorici ed esperimenti, spesso coronati dal Nobel,

per stabilire questa tabella che è diventata la "bibbia" di ogni

fisico. Ma c'è un problema. Così com'è strutturato, il Modello è

"vittima" di una sua stessa incoerenza. A livello puramente

matematico, il Modello Standard funzionerebbe perfettamente anche con particelle

prive di massa, o di massa tutta uguale. Per far si che di queste diverse

soluzioni resti valida solo quella corrispondente alla realtà, cioè quello che

descrive particelle dotate di massa, il fisico Peter Higgs ha proposto di

aggiungere al Modello Standard l'esistenza di un'altra particella, quella che

appunto prende il nome da lui. Così si chiarirebbe la questione dell'origine

della massa e il modello diverrebbe coerente anche dal punto di vista

matematico. Questa teoria può spiegare anche perché la massa acquisita varia

da particella a particella: ciò dipende dalle interazioni delle particelle con

il campo di Higgs. Come già detto, la particella di Higgs è ancora puramente

teorica: la sua individuazione è una delle principali poste in gioco della

fisica delle alte energie di oggi, una vera e propria caccia che vede impegnati

i più potenti acceleratori del mondo. Protagonisti sono il CERN di Ginevra ed

il FERMILAB di Chicago, così chiamato in onore di Enrico Fermi. Questi due

centri di ricerca, i più importanti a livello mondiale, sono equipaggiati con i

più potenti acceleratori: il Tevatron negli States e il LEP in

Svizzera. Di questi due, il Tevatron sembra avere più chances di riuscita, se

non altro per la maggior energia di cui è dotato. Il proseguimento degli

esperimenti deciso nel '99 fino al 2005 aprirebbe al Fermilab la possibilità di

trovare la particella di Higgs prima del Large Hadron Collider (LHC), i

gigantesco acceleratore che il CERN ha progettato e sta costruendo proprio per

trovare e studiare l'inafferrabile particella. Costerà qualcosa come 3000

miliardi, più 1000 per gli esperimenti.

Tutte

le conoscenze acquisite dalla fisica negli ultimi quarant'anni sono condensate

in quello che gli scienziati chiamano "Modello Standard", la

spiegazione più esauriente delle particelle fondamentali e delle loro

interazioni. Il Modello riesce a spiegare tutti i tipi osservabili di materia,

che è composta solo da dodici particelle base: sei tipi di quark e sei tipi di

leptoni, raggruppati in tre famiglie. Spiega inoltre le possibili interazioni

tra queste particelle e le quattro forze fondamentali. Sono stati necessari

oltre trent'anni di sforzi teorici ed esperimenti, spesso coronati dal Nobel,

per stabilire questa tabella che è diventata la "bibbia" di ogni

fisico. Ma c'è un problema. Così com'è strutturato, il Modello è

"vittima" di una sua stessa incoerenza. A livello puramente

matematico, il Modello Standard funzionerebbe perfettamente anche con particelle

prive di massa, o di massa tutta uguale. Per far si che di queste diverse

soluzioni resti valida solo quella corrispondente alla realtà, cioè quello che

descrive particelle dotate di massa, il fisico Peter Higgs ha proposto di

aggiungere al Modello Standard l'esistenza di un'altra particella, quella che

appunto prende il nome da lui. Così si chiarirebbe la questione dell'origine

della massa e il modello diverrebbe coerente anche dal punto di vista

matematico. Questa teoria può spiegare anche perché la massa acquisita varia

da particella a particella: ciò dipende dalle interazioni delle particelle con

il campo di Higgs. Come già detto, la particella di Higgs è ancora puramente

teorica: la sua individuazione è una delle principali poste in gioco della

fisica delle alte energie di oggi, una vera e propria caccia che vede impegnati

i più potenti acceleratori del mondo. Protagonisti sono il CERN di Ginevra ed

il FERMILAB di Chicago, così chiamato in onore di Enrico Fermi. Questi due

centri di ricerca, i più importanti a livello mondiale, sono equipaggiati con i

più potenti acceleratori: il Tevatron negli States e il LEP in

Svizzera. Di questi due, il Tevatron sembra avere più chances di riuscita, se

non altro per la maggior energia di cui è dotato. Il proseguimento degli

esperimenti deciso nel '99 fino al 2005 aprirebbe al Fermilab la possibilità di

trovare la particella di Higgs prima del Large Hadron Collider (LHC), i

gigantesco acceleratore che il CERN ha progettato e sta costruendo proprio per

trovare e studiare l'inafferrabile particella. Costerà qualcosa come 3000

miliardi, più 1000 per gli esperimenti.

Il problema

legato all'osservazione della particella di Higgs è legata, guarda caso, alla

sua massa.

I fisici americani stimano che la massa del bosone di Higgs sia leggermente

inferiore ai 130 GeV: a confronto, il protone a massa pari ad un GeV, mentre la

particella più massiccia finora osservata, il quark top, individuata proprio al

Fermilab, ha una massa pari a 174 GeV. Per questo trovare la Higgs al Tevatron

prima che LHC cominci a funzionare non è un'idea da escludere.

Secondo i fisici del CERN, il limite inferiore dell'inafferrabile particella è

di 109 GeV, valore raggiungibile anche nell'acceleratore del centro ricerche

Europeo, il LEP. Se così fosse, Higgs potrebbe essere quindi trovato anche al

LEP, tanto che più che lo scorso agosto l'acceleratore ha raggiunto la sua

massima energia, pari a 200 GeV. Le speranze comunque di individuare la

particella al CERN entro l'estate sono comunque deboli: poi il LEP verrà

smantellato ad ottobre, per far posto, nello stesso tunnel sotterraneo, al più

potente acceleratore LHC. E fino al 2005, quando l'LHC entrerà in funzione, non

ci saranno più acceleratori in grado di raggiungere l'energia necessaria. Se la

massa della particella di Higgs fosse comunque compresa tra 130 e 180 GeV,

bisognerà comunque attendere la stagione sperimentale del 2005 del Tevatron per

avere l'energia che serve. Se invece sarà superiore a questa stima, potrà

essere individuata da LHC, che raggiungerà addirittura i 14.000 GeV.

L’origine

delle particelle: il Big Bang

Tutto ciò che possiamo vedere e misurare proviene dal nulla ed è stato

creato nel corso del Big Bang. In un istante infinitesimo il nostro universo, e

con esso lo spazio ed il tempo, hanno avuto origine a partire da un minuscolo

‘embrione cosmico’ incredibilmente caldo e denso. Oggi molti miliardi di

anni dopo, l’universo si sta espandendo in tutte le direzioni. Le galassie

dell’universo si stanno allontanando le une dalle altre, e tanto più lontane

si trovano tra loro tanto più velocemente viaggiano nello spazio. Questa

importane scoperta, l’espansione dell’universo, venne enunciata nel 1929

dall’astronomo americano Edwin

Hubble (1889- 1953).

Intanto

alcuni astrofisici fanno osservare che quello che noi chiamiamo Big Bang

potrebbe anche non rappresentare la vera nascita dell'universo. Infatti, per la

teoria delle superstringhe (una teoria matematica assai complessa), il Big Bang

potrebbe essere solo un fenomeno, una specie di rimbalzo di un mondo precedente,

destinato ad attraversare una serie di collassi e nuove espansioni.

Se potessimo far scorrere indietro nel tempo questa

espansione, potremmo osservare le galassie raggrupparsi in uno spazio molto

ridotto e scopriremmo che l’intero universo, assai prima della loro

formazione, era più piccolo del nucleo di un atomo e aveva una temperatura

altissima. Il fatto che le galassie si stiano allontanando da noi potrebbe farci

pensare di essere in un luogo privilegiato al centro dell’universo, ma ciò

non è vero. La distanza tra noi e le altre galassie, infatti, continua ad

aumentare. L’universo si espande in tutte le direzioni allo stesso modo. Non

abbiamo alcuna possibilità di sapere che cosa esistesse prima del Big Bang: si

tratta di una domanda alla quale la scienza non può ancora rispondere. Inoltre

non dobbiamo immaginare il Big Bang come una normale esplosione, che avvenga in

un certo istante, in un certo luogo dello spazio. Prima del Big Bang non vi era

lo spazio e non vi era il tempo, i quali iniziarono ad esistere proprio con

questo evento. Da quel momento l’universo iniziò a espandersi, trascinando

con sé lo spazio e il tempo. Nessuno conosce con esattezza l’età

dell’universo, anche se, come dimostrò Hubble, questo dato è legato alle

dimensioni (calcolabili tramite l’effetto doppler) e alla velocità con cui

l’universo si sta espandendo. È possibile valutare le dimensioni

dell’universo cercando di misurare la distanza delle galassie più lontane,

anche se questo tipo di misurazione richiede l’utilizzo dei più potenti

telescopi esistenti e ha, in ogni caso, un notevole margine d’incertezza. Le

stime degli astronomi dicono comunque che l’età dell’universo è di circa

15 miliardi di anni.

Nell'istante del Big Bang

l'universo aveva volume nullo e temperatura infinita, ma, con il procedere

dell'espansione, la temperatura diminuì. I primi secondi sono probabilmente

molto ricchi di avvenimenti che si sono verificati ad un ritmo elevatissimo ed

hanno determinato la futura struttura dell'universo, che ha avuto inizio dalle

sostanze più semplici (protoni, neutroni ed elettroni) in una forma dissociata.

Un secondo dopo la temperatura era scesa a circa 10 miliardi di gradi e

nell'universo dovevano trovarsi soprattutto fotoni, elettroni e neutrini,

insieme a pochi protoni e neutroni. Oggi sappiamo che le particelle di materia e

quelle di antimateria, quando s’incontrano, si distruggono reciprocamente,

lasciando dietro di sé una certa quantità d’energia. Ciò accadde anche alle

coppie elettone- positrone all’inizio della storia dell’universo, le quali

si annichilarono lasciando energia e altre particelle elementari: i neutrini.

Tuttavia, da questa fase deve essere rimasto un eccesso di materia rispetto

all’antimateria, poiché tutto ciò che osserviamo oggi nel nostro universo è

costituito da materia, mentre l’antimateria è praticamente assente. Due

minuti dopo l'esplosione iniziale, la temperatura era scesa ad un miliardo di

gradi e protoni e neutroni cominciarono ad unirsi, producendo nuclei di

deuterio, i quali si combinarono con altri protoni e neutroni, formando nuclei

di elio. I nuclei degli atomi che noi conosciamo si sono formati a partire da

questa materia prima. Da questo momento in poi l’universo continuò ad

espandersi, raffreddandosi, permettendo la formazione di zone più dense, in cui

l’attrazione gravitazionale tra le particelle di materia permise la loro

aggregazione e l’avvio di un moto rotatorio, che diede origine alle galassie.

Con il passare del tempo, al contrarsi progressivo delle nubi di H ed He

, si verificarono collisioni fra gli atomi che innescarono le reazioni di

fusione nucleare e diedero origine alle stelle.

Oggi

la teoria del Big Bang non si trova di fronte a problemi insormontabili, seppure

esistano ancora questioni irrisolte. Anzi, si può affermare che le previsioni

di questa teoria abbiano superato tutte le verifiche cui sono state sottoposte e

si ritiene che qualunque nuova teoria cosmologica non potrà fare a meno di

incorporare l'idea di un big bang. Tuttavia il modello del Big Bang arriva solo

fino ad un certo punto e non ci spiega com'era l'universo prima dell'espansione

e che cosa accadrà nel lontano futuro, quando anche l'ultima stella avrà

esaurito il suo combustibile nucleare.

Alcune applicazioni

Fissione

nucleare

Dopo

la scoperta del neutrone da parte di Chadwick nel 1932, i fisici compresero di

avere la chiave per manipolare il nucleo atomico. Infatti, il neutrone non

possiede carica ed è capace di penetrare fin dentro il nucleo senza interagire

con le cariche delle altre particelle (protoni ed elettroni). Vari nuclei furono

bombardati con neutroni dai fisici, e tra loro c'era anche Enrico Fermi che

scoprì per primo circa trentasei nuovi isotopi radioattivi. Fermi, inoltre,

scoprì che se il neutrone che è sparato contro il nucleo viene rallentato fino

a raggiungere la velocità termica, la normale velocità del moto degli atomi,

ha una maggiore probabilità di venir assorbito da un nucleo, perché resta più

a lungo nelle sue vicinanze. La probabilità che una data specie di nucleo

catturi un neutrone è chiamata sezione d'urto, termine che descrive il nucleo

come un bersaglio di determinata grandezza. Quando un nucleo cattura un

neutrone, il suo numero atomico rimane invariato perché la carica del nucleo

non viene alterata, mentre il peso atomico sale di un'unità. L'energia

conferita al nucleo dall'ingresso del neutrone può eccitare il nucleo, cioè

accrescere il suo contenuto energetico. Questo surplus di energia viene poi

emesso sotto forma di raggio gamma, ma il nuovo nucleo che si è formato spesso

è instabile. Dato che il bombardamento con i neutroni è un facile metodo per

convertire un elemento in quello successivo, Fermi pensò di bombardare un atomo

di uranio per vedere se si sarebbe creato in modo artificiale un nuovo elemento.

Ci volle un po' di tempo da parte dei fisici di tutto il mondo per capire che il

prodotto del bombardamento dell'uranio non era in realtà un nuovo elemento ma

due elementi con peso atomico uguale alla metà di quello dell'uranio ; in

parole povere il bombardamento aveva spezzato in due l'atomo, era avvenuta una

fissione nucleare. La fissione liberava una quantità straordinaria di energia,

di gran lunga superiore della semplice radioattività, e durante la reazione

venivano liberati due o tre neutroni. Quest'ultimo fatto era estremamente

importante, poiché ciò rendeva possibile la realizzazione di una reazione

nucleare a catena che permetteva la produzione di notevoli quantità di

energia. Ma in quel periodo il mondo si trovava a dover affrontare la Seconda

Guerra Mondiale, e subito fu compresa la possibilità di utilizzare quell'energia

per scopi bellici.

Fusione

nucleare

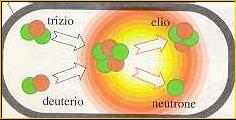

Nel frattempo la bomba a fissione è diventata

un'arma superata : gli uomini riuscirono ad innescare un'altra reazione

nucleare capace di produrre bombe ancora più devastanti. A temperature molto

alte, nell'ordine dei milioni di gradi, l'energia dei protoni è abbastanza

sufficiente per consentire la loro fusione : così due protoni di due atomi

di idrogeno si possono unire, e dopo aver emesso un positrone e un neutrino

(processo che converte uno dei protoni in un neutrone) costituiscono un nucleo

di deuterio, un isotopo dell'idrogeno. Questo, a sua volta, può fondersi con un

protone dando origine a un nucleo di trizio, che può fondersi con un altro

protone formando un nucleo di elio 4 ; oppure i nuclei di deuterio e di

trizio possono combinarsi in altri modi, formando sempre elio 4.

Nel frattempo la bomba a fissione è diventata

un'arma superata : gli uomini riuscirono ad innescare un'altra reazione

nucleare capace di produrre bombe ancora più devastanti. A temperature molto

alte, nell'ordine dei milioni di gradi, l'energia dei protoni è abbastanza

sufficiente per consentire la loro fusione : così due protoni di due atomi

di idrogeno si possono unire, e dopo aver emesso un positrone e un neutrino

(processo che converte uno dei protoni in un neutrone) costituiscono un nucleo

di deuterio, un isotopo dell'idrogeno. Questo, a sua volta, può fondersi con un

protone dando origine a un nucleo di trizio, che può fondersi con un altro

protone formando un nucleo di elio 4 ; oppure i nuclei di deuterio e di

trizio possono combinarsi in altri modi, formando sempre elio 4.

Queste reazioni avvengono solo in presenza di

altissime temperature, per questo vengono chiamate reazioni termonucleari. Negli

anni trenta si credeva che queste temperature fossero raggiunte soltanto

all'interno delle stelle, ma con la bomba basata sulla fissione dell'uranio

l'uomo fu capace di raggiungere le temperature necessarie anche sulla terra. La

fissione poteva così innescare nell'idrogeno una reazione di fusione nucleare a

catena.

Bibliografia